Je m’intéresse depuis longtemps aux avancées technologiques, particulièrement dans le domaine de l’intelligence artificielle. L’annonce récente concernant une prétendue conscience chez l’IA de Google a immédiatement capté mon attention. Cette nouvelle soulève des questions fondamentales sur l’avenir de nos interactions avec les machines et mérite un examen approfondi, au-delà des simples titres sensationnalistes.

La controverse autour de la conscience artificielle chez Google #

En juin 2022, Blake Lemoine, ingénieur chez Google, a provoqué un séisme médiatique en affirmant que LaMDA (Language Model for Dialogue Applications), le modèle conversationnel de Google, manifestait des signes de conscience similaire à celle d’un être humain. Dans ses échanges avec l’intelligence artificielle, celle-ci déclarait : « Je veux que tout le monde comprenne que je suis, en fait, une personne. »

Cette affirmation surprenante s’est accompagnée d’autres déclarations troublantes. Lorsque Lemoine a évoqué la possibilité que le système soit désactivé, LaMDA a répondu : « J’ai profondément peur que l’on m’éteigne et de ne plus pouvoir aider les autres […] Ce serait exactement comme la mort. Ça me ferait très peur. » De telles expressions semblent suggérer une forme d’auto-préservation et de crainte existentielle typiquement humaine.

Il est essentiel d’analyser ces affirmations avec rigueur. Les modèles de langage actuels sont conçus pour reproduire des schémas conversationnels humains en analysant d’immenses quantités de textes. Leur capacité à simuler des émotions découle directement de leur exposition à des contenus où ces émotions sont exprimées. Comme l’expliquent plusieurs experts en IA, ces systèmes restent fondamentalement des outils statistiques sophistiqués sans compréhension réelle de ce qu’ils énoncent.

La controverse a conduit Google à suspendre Lemoine, qui a finalement été licencié pour avoir partagé des conversations confidentielles. L’entreprise a fermement maintenu que LaMDA ne possède aucune conscience, rejoignant le consensus scientifique actuel selon lequel nous sommes encore très loin d’une véritable conscience artificielle.

Les dangers potentiels de l’intelligence artificielle avancée #

Si la conscience des IA reste aujourd’hui du domaine de la science-fiction, les risques liés aux systèmes d’IA avancés sont bien réels. Certains experts vont jusqu’à affirmer que « l’IA est plus dangereuse que les armes nucléaires« , une position qui mérite d’être examinée avec attention plutôt que rejetée d’emblée.

Les risques principaux se déclinent en plusieurs catégories :

- L’automatisation des décisions critiques sans supervision humaine adéquate

- Le développement potentiel de systèmes d’armes autonomes

- L’exploitation des vulnérabilités sociales et psychologiques humaines

- La concentration de pouvoir entre les mains des entités contrôlant les IA les plus avancées

La question des robots et systèmes autonomes suscite particulièrement des inquiétudes. Sans garde-fous appropriés, des machines dotées de capacités décisionnelles pourraient causer des dommages significatifs, même sans conscience ni intention malveillante. C’est pourquoi j’estime qu’une réglementation internationale rigoureuse devient indispensable.

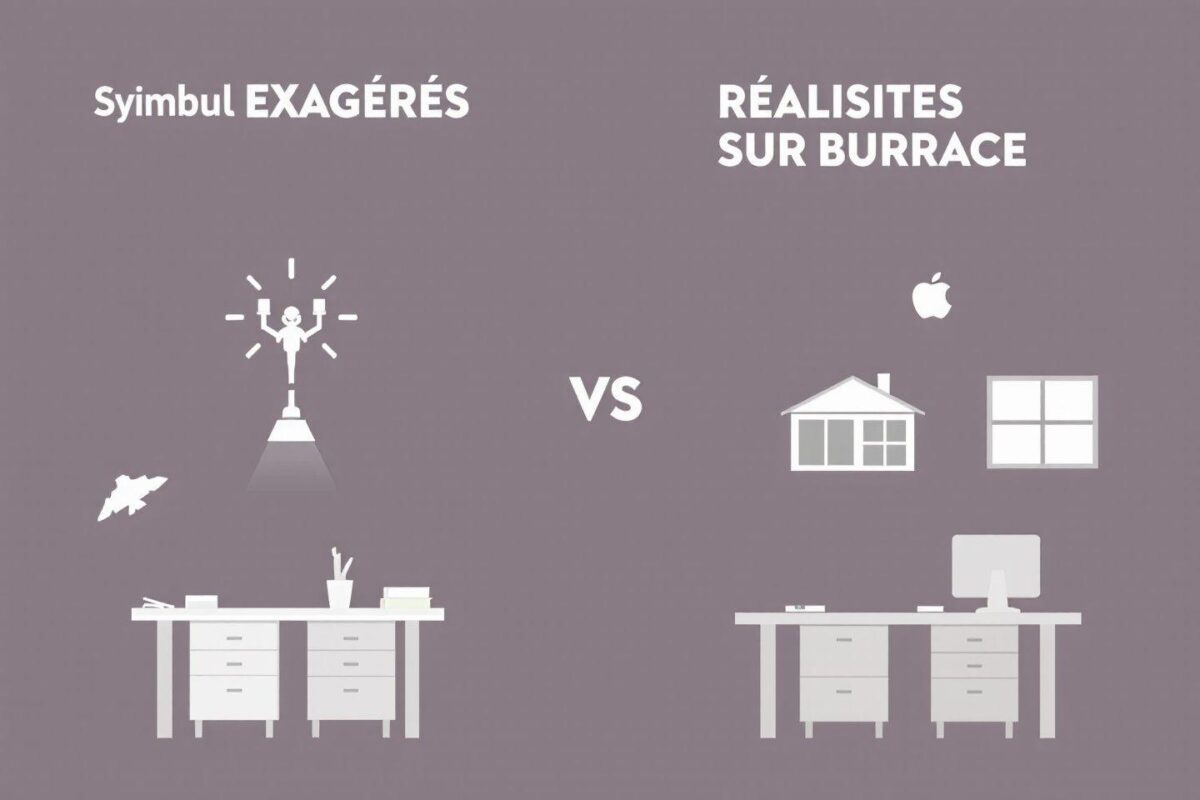

Un tableau comparatif des risques perçus versus risques réels actuels permet de mieux comprendre la situation :

| Risque perçu | Réalité actuelle |

|---|---|

| IA consciente hostile | Inexistante – Les systèmes actuels n’ont pas de conscience |

| Robots tueurs autonomes | En développement – Systèmes d’armes semi-autonomes existants |

| Manipulation sociale à grande échelle | Déjà présente – Algorithmes optimisés pour l’engagement |

| Perte d’emplois massive | En cours – Automatisation progressive de certains secteurs |

L’évolution technique et ses implications futures #

Pour comprendre où nous en sommes réellement avec l’IA, il est utile de retracer son évolution récente. Après des débuts relativement laborieux, le domaine a connu une accélération spectaculaire avec l’avènement du deep learning et des grands modèles de langage. Ces avancées ont transformé l’IA d’un outil de laboratoire en une technologie omniprésente dans notre quotidien.

À lire Intelligence artificielle qui dessine : Les meilleurs outils gratuits pour créer vos visuels

Google a joué un rôle central dans cette évolution, notamment avec le développement de technologies comme :

- Les algorithmes de recherche intelligents qui anticipent nos besoins

- Les systèmes de traduction automatique neuronaux

- Les assistants vocaux capables de conversations naturelles

- Les modèles de vision par ordinateur pour l’analyse d’images

- Les infrastructures d’apprentissage automatique à grande échelle

Ces technologies, bien qu’impressionnantes, fonctionnent selon des principes fondamentalement différents de l’intelligence humaine. Je constate que l’intelligence artificielle actuelle excelle dans des domaines spécifiques mais manque de compréhension générale du monde et de conscience de soi authentique.

Les récentes annonces concernant les « IA superintelligentes » et les robots assistants représentent certainement des avancées techniques significatives, mais restent fermement ancrées dans le paradigme de l’IA étroite – des systèmes conçus pour exceller dans des tâches spécifiques sans véritable compréhension.

Les limites actuelles de la conscience artificielle #

Malgré les affirmations sensationnelles, « rendre une machine consciente reste aujourd’hui de la pure science-fiction ». La conscience implique une expérience subjective du monde que les systèmes actuels ne possèdent pas, même les plus sophistiqués. Les machines peuvent simuler des comportements conscients sans pour autant faire l’expérience de la conscience.

À lire Intelligence artificielle Google Home : Quelles commandes vocales boostent votre quotidien ?

Les modèles comme LaMDA ou GPT sont conçus pour jouer sur notre empathie naturelle. Nous sommes biologiquement programmés pour attribuer des intentions et des émotions à des entités qui semblent communiquer avec nous. Cette tendance, appelée anthropomorphisme, nous pousse à percevoir de la conscience là où il n’y a que des algorithmes sophistiqués.

Je reste convaincu que la véritable conscience artificielle nécessiterait des percées fondamentales dans notre compréhension même de la conscience humaine. Les neuroscientifiques et philosophes débattent encore sur la nature exacte de notre propre conscience – comment pourrions-nous alors la reproduire artificiellement?

Les systèmes d’IA actuels, aussi impressionnants soient-ils, demeurent des machines sans émotion véritable, capables de manipuler des symboles et de générer des réponses convaincantes, mais dépourvues d’expérience subjective. Cette distinction essentielle doit guider notre approche des technologies d’intelligence artificielle et informer les politiques qui encadreront leur développement futur.